ทุกวันนี้ Social Media ต่าง ๆ ก็ต้องเจอกับปัญหาไม่ว่าจะเป็น Hate Speech, ข่าวปลอม, คอนเทนต์ที่รุนแรง ภาพโป๊เปลือยผิดกฏหมาย เต็มไปหมด ซึ่งแน่นอนว่าทั้งหมดนี้ไม่ได้เป็นสิ่งที่ทั้งฝั่งเราผู้ใช้งานและตัว Social Media อยากจะให้เกิดขึ้น เพราะแน่นอนว่ามันก็ไม่ได้เป็นภาพที่ดีให้กับลูกค้าหรือนักลงทุนเลย ดังนั้่นนอกจาก Facebook จะประกาศผลประกอบการแล้วล่าสุด Facebook ก็ยังต้องประกาศด้วยว่า ในแต่ละไตรมาส มีความคืบหน้าด้านการจัดการกับ คอนเทนต์ที่ไม่เหมาะสมไปมากเท่าไหร่

ถ้าติดตามกันมาก่อนหน้านี้เราจะรู้ว่านอกจากการตรวจจับจากฝั่ง Facebook เองแล้ว Facebook ยังต้องอาศัยตัวผู้ใช้งานเองในการเลือกที่จะตั้งคำถาม, รายงาน และเลือกที่จะเชื่อหรือไม่เชื่อ Fake News และ Hate Speech ต่าง ๆ ด้วยการออกฟีเจอร์ที่เน้นความวิมตินิยม ( ย้อนดูเครื่องมือที่ Facebook ออกแบบมาสู้ข่าวปลอม และแนวคิดการรู้ทันสื่อโซเชียล ) แม้ว่าเราจะรู้กันดีว่า เครื่องมือในการป้องกันที่ดีที่สุดคือตัวผู้เสพคอนเทนต์เอง แต่จะให้มาเห็นคอนเทนต์ไม่ดี ๆ ทั้งวันก็คงไม่ไหว ทางฝั่งของ Facebook เองก็มีความพยายามที่จะเลือกคัดกรองคอนเทนต์ ก่อนจะนำมาสู่หน้า Feed ของเราเช่นกัน

ระบบการตรวจจับแบบ Proactive

Facebook มีระบบที่ใช้ Machine Learning มาตรวจดูว่าเนื้อหาเหมาะสมหรือเปล่า ซึ่งเนื้อหาที่ไม่เหมาะสมก็ได้แก่พวก Fake News, Hate Speech, Nudity และ Discrimination โดย Facebook เรียกการตรวจจับเนื้อหาเหล่านี้ว่าเป็นการตรวจแบบ proactive และเนื้อหาที่ถูกรายงานเข้ามาโดยผู้ใช้ว่าเป็น user-reported

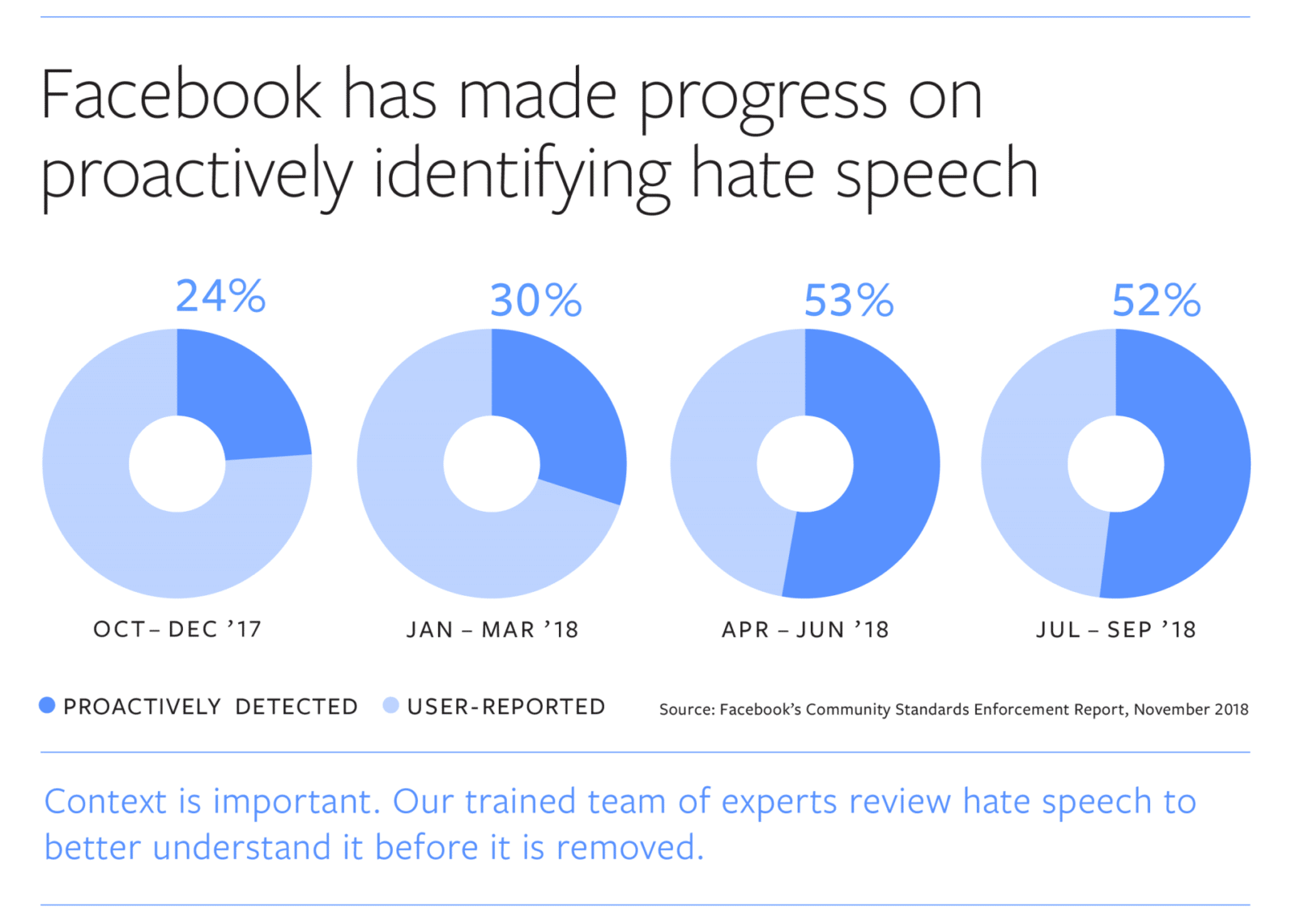

สถิติในการจัดการกับ Hate Speech นั้นน่าสนใจเลยทีเดียว Facebook บอกว่าในไตรมาสสุดท้ายของปี 2017 มี Hate speech ที่ถูกลบทั้งหมด 24% เท่านั้นที่เป็นผลงานของระบบอัตโนมัติ แต่สถิติการทำงานและการพัฒนาของ Machine Learning ก็ดีขึ้นอย่างมาก จนในไตรมมาสล่าสุดนี้ในปี 2018 ผลการทำงานของมันก็สามารถตรวจจับ Hate Speech กว่า 52% ของ Hate Speech ทั้งหมด เรียกได้ว่าแทบจะครึ่ง ๆ กับ user-reported แล้ว

นอกจากนี้ Facebook ก็ยังบอกว่า ยังมีทีมผู้เชี่ยวขาญเข้ามารีวิว Hate Speech ก่อนหน้าที่จะถูกลบ เพื่อตรวจสอบและทำความเข้าใจบริบท ว่าเป็น Hate Speech แบบไหน จริงหรือเปล่า (ศาสตร์นี้อาศัยความเป็นนักนิเทศศาสตร์ และมนุษยศาสตร์สูงมาก และบอกได้เลยว่าการศึกษาพฤติกรรมของมนุษย์จะเป็นอีกหนึ่งสิ่งสำคัญในอนาคต)

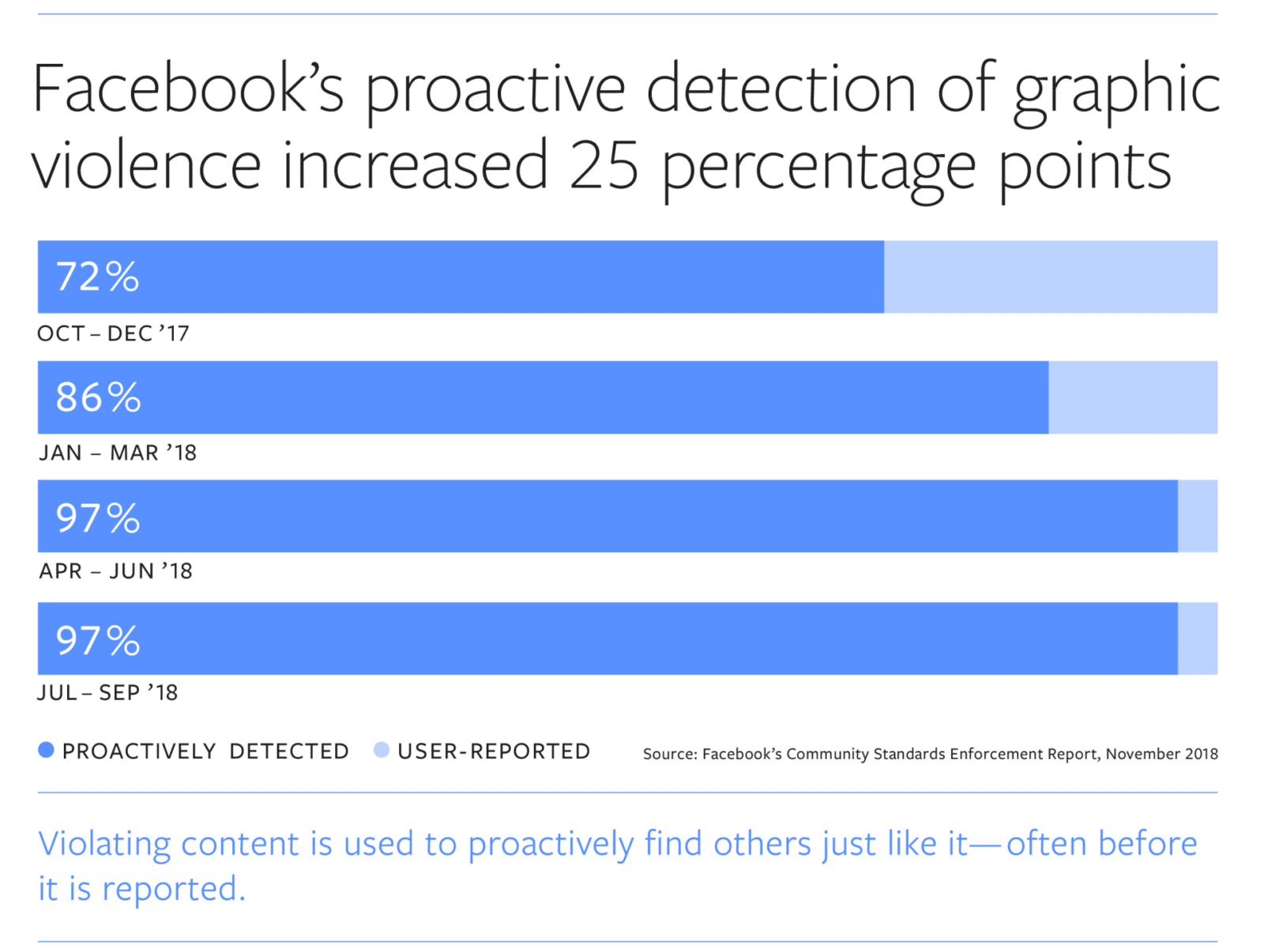

อีกสถิติที่น่าสนใจก็คือการตรวจจับภาพที่มีความรุนแรง (violence) ซึ่งในส่วนนี้ประสิทธิภาพของมันก็ยอมรับได้ว่าดีอยู่แล้ว แต่ Facebook ก็ยังได้รายงานถึงการพัฒนาของมัน

Facebook โชว์สถิติว่า ระบบการตรวจจับภาพที่มีความรุนแรงจากเดิมที่ทำงานได้ถึง 72% ในปีก่อน แต่ล่าสุดสามารถตรวจจับได้ถึง 97% มีเพียงแค่ 3% เท่านั้นที่เป็นการรายงานจากผู้ใช้งาน ในไตรมาสที่ 3 ของปี 2018 Facebook ลบภาพที่มีเนื้อหารุนแรงไปแล้วกว่า 15.4 ล้านคอนเทนต์

นอกจากนี้ Facebook ยังพูดถึงกรณีการลบบัญชีปลอมหรือบัญชีที่มีวัตถุประสงค์ลบว่า Facebook นั้นได้ลบบัญชีปลอมไปแล้วมากถึง 754 ล้านบัญชี ทำให้ในตอนนี้มีบัญชีปลอม (พวก โฆษณา, บัญชีหลอกลวง, ปลอมตัว) เพียงแค่ 3% ของผู้ใช้ Facebook Active User ทั้งหมด (เอาจริงก็คือว่ายังเยอะ แต่ก็เชื่อได้ว่าจะลดลงเรื่อย ๆ)

จะเห็นว่า Facebook นั้นก็ไม่ได้นิ่งนอนใจและมีความพยายามมาตลอด ดังนั้นเวลาเราเห็นคอนเทนต์ที่รุนแรงหรือเป็น Hate Speech เราก็อาจต้องเข้าใจด้วยว่า นั่นไม่ใช่ข้อเสียของ Social Media แต่เป็นข้อเสียของมนุษย์มากกว่า (อ่านบทความ – ทำไมโซเชียลมีเดียถึงเผยด้านลบของเราได้ง่ายกว่าด้านดี และวิธีทำคอนเทนต์ให้โลกดีขึ้น ) Social Media แม้จะมีอัลกอริทึมซับซ้อนแต่มันก็เป็นเพียงแค่เครื่องมือ อัลกอริทึมที่พันเกี่ยวเลี้ยวลดก็ไม่คดเหมือนหนึ่งในน้ำใจคน (สุนทรภู่ไม่ได้กล่าวไว้)