การที่เว็บไซต์ของเราไปปรากฎอยู่บน Google ต้องผ่านขั้นตอนอันซับซ้อนมากมาย ขั้นตอนส่วนหนึ่งเริ่มมาจาก Googlebot ได้ออกไปกวาดหาคอนเทนต์ต่างๆ บนโลกอินเตอร์เน็ตเพื่อรวบรวมข้อมูลก่อนที่จะมาจัดอันดับ

ซึ่งเป็นเรื่องที่ดีหากเราทราบการทำงานเบื้องต้นของ Googlebot เพื่อที่เราจะได้จัดการคอนเทนต์ให้เหมาะสม จากนั้น Google จะได้รักเราสักที

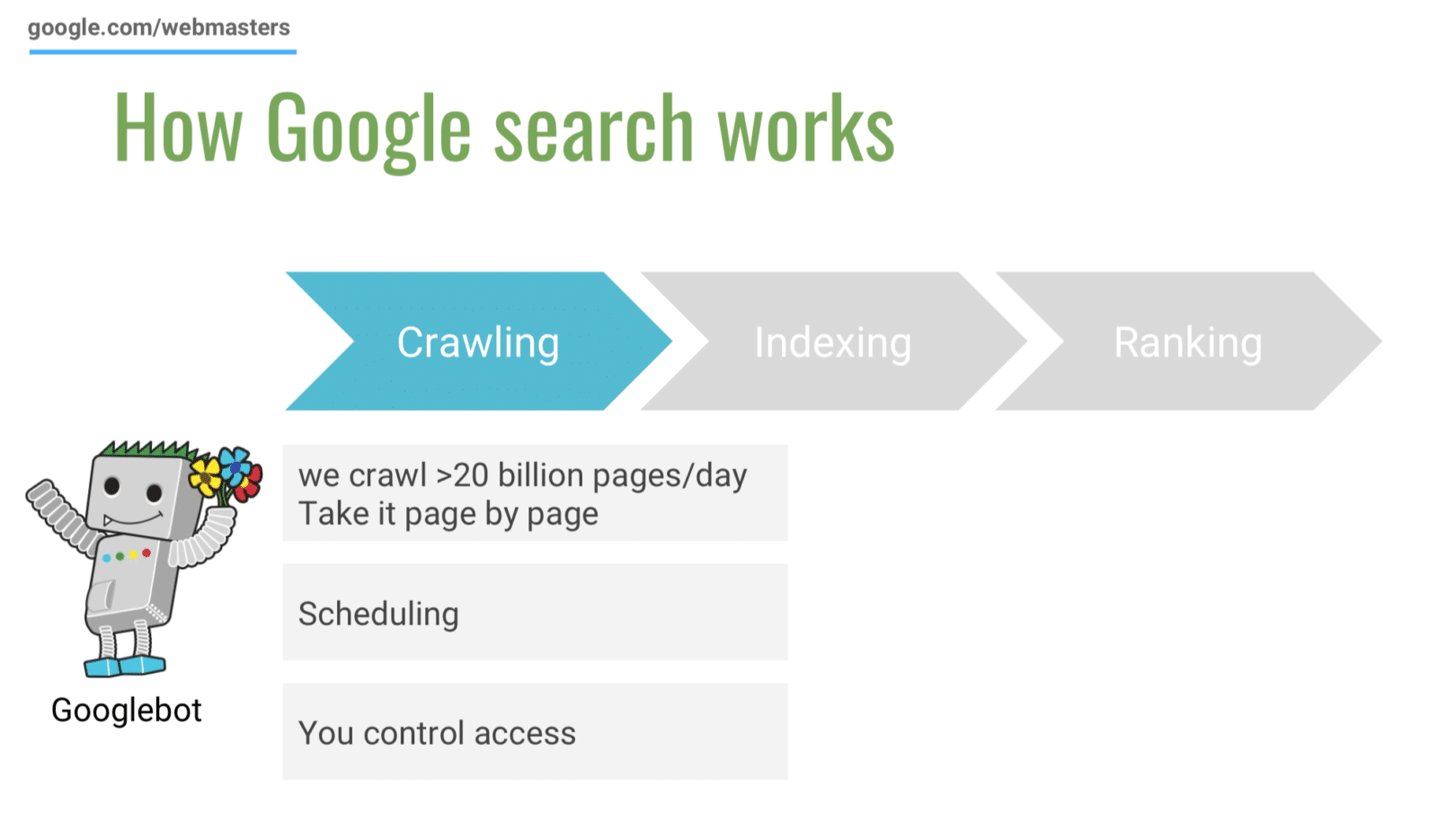

กระบวนการทั้งหมดของ Google Search

กระบวนการหลักของ Google Search ก่อนที่จะมาแสดงผลให้เราตอนที่เราค้นผ่านเว็บ Google มีอยู่ 3 ขั้นตอนได้แก่ Crawling > Indexing > Ranking

- Crawling : เริ่มจาก Google ส่ง Bot กระจายออกไปเก็บข้อมูลเว็บไซต์ทั่วโลกและรวบรวมเก็บไว้ตามเวลาที่กำหนด ซึ่งหมายความว่าข้อมูลของเว็บไซต์เราบน Google ไม่ได้อัปเดตแบบ realtime แต่ก็มีช่วงเวลาการอัปเดตอย่างเหมาะสมของแต่ละเว็บไซต์ หรือเจ้าของเว็บเองก็สามารถกำหนดความถี่ในการให้ bot เข้ามาเก็บได้ผ่าน Google Search Console

- Indexing : หลังจากที่ Bot เก็บรวบรวมข้อมูลเว็บไซต์จากทั่วโลกมา Google จะนำมาคิดว่าหน้าเว็บไหนบ้างที่ควรเข้ามาอยู่ในระบบ โดย Google ไม่ได้ดูเพียง keyword ในหน้านั้นๆ เท่านั้น แต่ยังมีอัลกอริทึมที่ซับซ้อนลงไปอีก และไม่ใช่ทุก URL ของเว็บที่จะถูกจัดเก็บ แต่จะมีปัจจัยหลายอย่างในการคัดเลือก เช่น ถ้ามี 2 หน้าที่มีข้อมูลเหมือนกันเป๊ะ Google อาจจะเลือกมาเพียงหน้าเดียว

- Ranking : ขั้นตอนสุดท้ายคือการนำสิ่งที่รวบรวมมาจัดอันดับการแสดงผล ซึ่งเป็นขั้นตอนที่ซับซ้อนมากที่สุด การจัดอันดับทำแบบ realtime โดยที่ข้อมูล 15% ที่ผู้ใช้ค้นหา เป็นข้อมูลที่ไม่เคยเจอมาก่อนบนหน้า Google ซึ่งจะใช้หลายปัจจัยมาคิดว่าผู้ใช้ต้องการผลลัพธ์อย่างไร เช่นถ้าคุณค้นหาคำว่า “ข้าวเหนียวไก่ย่าง” ระบบจะคิดด้วยว่าตอนนี้คุณค้นหาจากที่บ้านหรือขับรถอยู่ แล้วเลือกให้ว่าการแสดงผลควรจะเป็นสูตรการทำหรือข้อมูลของร้านอาหารดี

สามารถอ่านเพิ่มเติมในกระบวนการต่างๆ และการปรับปรุงเว็บไซต์เพิ่มได้ที่ สร้างตัวตนออนไลน์บน Google Search – ข้อมูลจาก Google ในงาน WordCamp Bangkok 2019

Googlebot คืออะไร?

Googlebot คือ webcrawler หรือโปรแกรมรวบรวมข้อมูลเว็บของ Google เปรียบเสมือนหุ่นยนต์ที่ส่งเข้าไปกวาดอ่านสิ่งต่างๆ ที่อยู่บนอินเตอร์เน็ต เพื่อรวบรวมข้อมูลมาเก็บไว้ในฐานข้อมูล เพื่อนำไปวิเคราะห์และจัดลำดับการแสดงผลต่อไป

โดย Googlebot จะเก็บข้อมูลทั้ง Web pages, ไฟล์หนังสือ, pucblic database, รูปภาพ, ข้อมูลจากผู้ใช้ (User-submitted) และอื่นๆ อีกมากมาย แต่ครั้งนี้เราจะมาโฟกัสที่ Web pages กัน

Googlebot มาทำอะไรกับเว็บของเราบ้าง?

หน้าที่หลักของ Googlebot คือการ crawling หรือการเข้ามาเก็บข้อมูลบนเว็บของเรา

เบื้องต้นหลังจาก Googlebot เข้ามาพบกับเว็บไซต์เราครั้งแรก เจ้าหุ่นยนต์จะเริ่มเข้าไปดู Sitemap ที่เราสร้างเอาไว้ คล้ายกับเวลาเราดูแผนที่ที่เจ้าหน้าที่ติดไว้หน้าห้าง ก่อนจะเข้าไปสำรวจลิงก์ต่างๆ โดยลิงก์ก็เปรียบเสมือนประตูที่จะทำให้ Googlebot เข้าไปในทุกส่วนได้ครบ

จากนั้นมันจะรวบรวมเนื้อหาทั้งหมดของเว็บไซต์ที่เข้าไปอ่าน ทั้งข้อความ ไฟล์มีเดีย ลิงก์ ละเอียดทุกซอกทุกมุม โดยการอ่านทั้ง code และข้อมูลหลังจากที่ code ได้ render สคริปต์ต่างๆ ออกมาเป็นหน้าเว็บไซต์อีกครั้งหนึ่ง เพื่อที่ได้ข้อมูลที่ถูกต้องที่สุด แล้วนำข้อมูลที่ได้จากเว็บเราบันทึกลงฐานข้อมูลของ Google สำหรับนำข้อมูลไปใช้งานอื่นต่อ

แต่ Googlebot นั้น ไม่ได้เข้ามาสำรวจเพียงครั้งเดียวนะ มันจะเข้ามาเรื่อยๆ ยิ่งเว็บมีการเปลี่ยนแปลงบ่อย มันก็จะยิ่งเข้ามาถี่มากขึ้น เพื่อที่จะอัปเดตข้อมูลของเว็บเราให้ได้เร็วที่สุด โดย Googlebot มันจะนำข้อมูลเก่ามาเทียบด้วย ว่าบนเว็บเรามีอะไรเกิดขึ้นบ้าง เรียกว่าคอยส่องทุกความเคลื่อนไหวเลยทีเดียว

สิ่งที่ ควรทำ เพื่อให้ Googlebot รู้จักเว็บของเรา

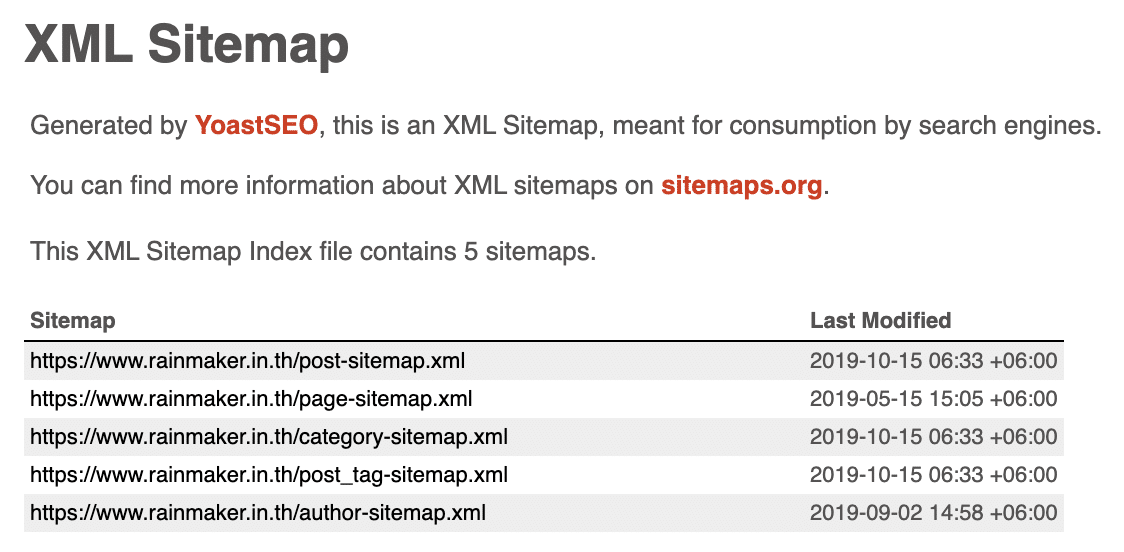

sitemap.xml แผนที่สำหรับ Googlebot

sitemap คือแผนผังเว็บไซต์สำหรับให้ซอฟต์แวร์อย่าง Googlebot เข้ามาอ่าน มีโครงสร้างมาตรฐานที่ทำให้เข้าใจทันทีว่าเว็บไซต์ของเรามีโครงสร้างเป็นอย่างไร สามารถตรวจสอบ sitemap ของเว็บไซต์คุณเอง โดยการเข้า URL ดังนี้ yourwebsite.com/sitemap.xml

ตัวอย่าง sitemap ของเว็บไซต์ RAiNMaker : https://www.rainmaker.in.th/sitemap.xml

หากคุณทำเว็บไซต์ด้วยตัวเองด้วย WordPress ในส่วนนี้ plugin SEO อย่าง YoastSEO จะช่วยคุณสร้าง sitemap ขึ้นมาให้อยู่แล้ว แต่ถ้าเว็บไซต์ที่คุณเขียนอยู่ ยังไม่มีในส่วนนี้ ต้องสะกิดให้ผู้ดูแลจัดการให้ หากขาดตรงนี้ไป เจ้า Googlebot อาจจะเข้ามาอัปเดตข้อมูลช้า หรืออาจเก็บข้อมูลโครงสร้างเว็บไซต์ผิดพลาดก็เป็นได้

robots.txt กำหนดวิธีที่ Googlebot เข้าชม

ถ้าเราพูดถึง sitemap ว่าเปรียบเหมือนกับป้ายแผนที่ที่อยู่หน้าห้าง robots.txt ก็เปรียบเสมือน รปภ. ก่อนเข้าห้าง โดย Googlebot จะเข้ามาอ่านไฟล์นี้ เพื่อดูว่าเว็บไซต์ที่กำลังจะเข้าไป มีส่วนไหนที่เจ้าของเว็บไซต์ไม่อนุญาตให้ Googlebot เข้าไปเก็บข้อมูลหรือไม่

ส่วนมากแล้วเราจะใช้ในกรณีที่เว็บไซต์มีหน้าที่เราไม่อยากให้ Googlebot เข้าไปค้นเจอหรือเก็บข้อมูล เราก็สามารถเขียนไฟล์ robots.txt เพื่อกำหนดหน้าต่างๆ ได้ ส่วนนี้จะค่อนข้าง technical เล็กน้อย สามารถแจ้งผู้ดูแลเว็บไซต์ หรือใช้ plugin มาจัดการได้ครับ

ติดตั้ง Google Search Console เพื่อติดตามผล SEO ของเว็บไซต์เรา

Google Search Console หรือชื่อเดิมของมันคือ Webmaster Tools (หากเคยได้ยินชื่อนี้ ให้ทราบไว้ว่าเป็นตัวเดียวกัน) เครื่องมือฟรีจาก Google ที่เอาไว้ตรวจสอบประสิทธิภาพของเว็บไซต์เรา

สิ่งที่เราสนใจบน Google Search Console

- คนเห็นเว็บไซต์เราด้วย keyword อะไร

- คนเข้าเว็บไซต์เราด้วย keyword อะไร

- ตรวจสอบความเรียบร้อยของเว็บไซต์ ว่าเราปูทางให้ Googlebot ได้ดีหรือยัง เช่น sitemap, มีหน้า error อยู่ไหม เป็นต้น

- ตรวจสอบได้ว่า Googlebot มองเห็นเว็บไซต์ของเราหรือยัง

สามารถอ่านรายละเอียดเพิ่มเติม และวิธีการติดตั้ง Google Search Console ได้ที่ : รู้จักกับ Google Search Console เครื่องมือดูแลเว็บไซต์ สำหรับสาย SEO

การทดสอบว่า Googlebot เห็นเว็บไซต์ของเราหรือยัง

วิธีการตรวจสอบว่า Googlebot นั้นมองเห็นเว็บไซต์เราหรือยัง ใช้ในกรณีที่เราเพิ่งขึ้นเว็บใหม่สดๆ ร้อนๆ หรือมีหน้าบทความใหม่ โดยการพิมพ์ข้อความดังต่อไปนี้ลงไปที่ address bar โดยนำชื่อเว็บไซต์ของคุณแทนที่ “yourwebsite.com”

site:yourwebsite.com

อีกหนึ่งวิธีที่สะดวกกว่า คือการใช้ URL inspection บน Google Search Console ในกรณีที่คุณได้สมัครใช้งาน Google Search Console ไว้แล้ว

ที่มา :